大模型管理底座ollama

目录

使用本地大模型作为个人AI助手

大模型在个人电脑上的应用

优势

- ㊙️数据安全性,隐私性

- 🕸️不依赖于网络

- 🐒灵活性,集成性

应用

- 💬本地ChatGPT (open webui)

- 📚本地知识库(anythingLLM)

- 🤖全领域AI助手 (openai translator)

什么是 ollama?

Ollama 是一个=框架=,旨在简化在本地部署和管理开源大型语言模型的过程。它支持一系列著名的模型,如 Llama 2, Mistral, Gemma 等,极大地简化了安装和配置的细节。Ollama 因其能够让用户轻松在本地运行大模型而广受好评。

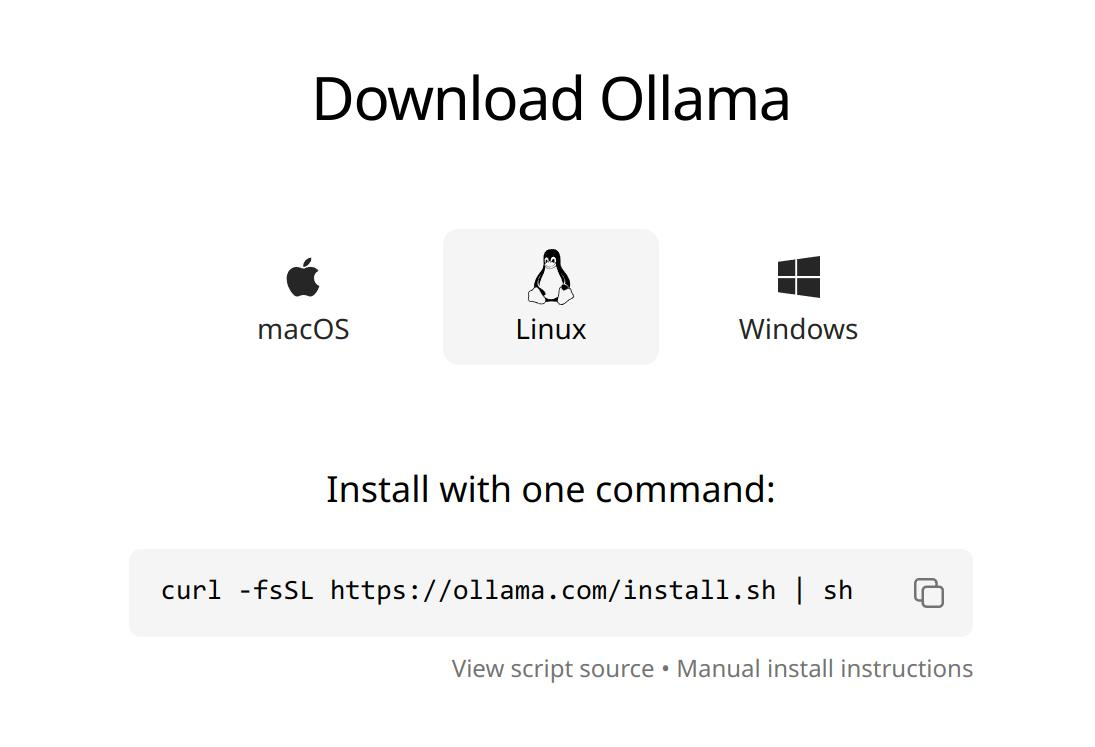

安装 ollama:

Windows和Mac直接下载安装即可。

Linux在终端中输入命令:

curl -fsSL https://ollama.com/install.sh | sh

下载模型

根据你想要的模型名称不同 pull 对应的名称。(可以参考前面我推荐的中文模型)

ollama pull llama2-chinese这就完成了!非常简单。

常用命令:

ollama list显示所有模型ollama pull xxx下载模型ollama run运行模型

终端使用

在终端上我们输入想问的问题:

ollama run llama2-chinese "天空为什么是蓝色的?"ollama 下载

如果你在官网下载很慢,可以使用我分享的网盘: https://pan.baidu.com/s/1qMiF14yYXdZk8tbZ4gnEyg?pwd=nigo